佳能推智能应用系统与产品版本升级,让4K摄控一体机应用领域更广泛

为了让摄控一体机获得更丰富的应用功能,佳能正式推出摄控一体机智能应用系统“Add-On应用系统”和“VAS应用系统”,可以让用户根据自身需求通过安装付费应用程序。Add-on应用系统包含佳能同步发布的自动追踪“RA-AT001”应用程序和自动巡视“RA-AL001”应用程序,VAS应用系统由自动追踪“RA-ST001”应用程序和图像增强“RA-IA001”应用程序构成,四款应用程序可广泛应用于纪录片、真人秀、媒体直播、电商直播等场景下的拍摄,也可以满足高端视频会议、远程教育等多样化场景需求,能够帮助用户更有效的提升拍摄效率。

自动追踪“RA-AT001”应用程序(左)与自动巡视“RA-AL001”应用程序(右)

进一步扩展摄控一体机自动化操作,有效提升拍摄效率

自动追踪“RA-AT001”应用程序和自动巡视“RA-AL001”应用程序,均是在摄控一体机内处理,所以硬件反应性能更为迅速、高效与稳定。目前,这两款应用程序可以配合佳能旗下面向中高端市场的室内4K摄控一体机CR-N700、CR-N500和CR-N300,以及户外4K摄控一体机CR-X300使用。未来,佳能将进一步扩大其兼容的摄控一体机型号,及其Add-On应用系统提供的应用程序阵容。

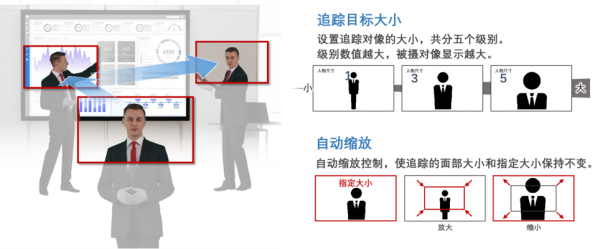

自动追踪“RA-AT001”应用程序能够使佳能摄控一体机在指定区域自动追踪拍摄对象。该应用程序拥有出色的追踪能力,并且具有灵活的视角,能够从全身、上半身、头像的视角进行拍摄。此外,该应用程序设有“构图设置”、“追踪灵敏度设置”、“优先显示区域”等丰富的调整功能,用户可以根据自身不同的使用场景进行更加精细化的设置,有效提升拍摄效率。

自动追踪“RA-AT001”应用程序的构图功能示意图

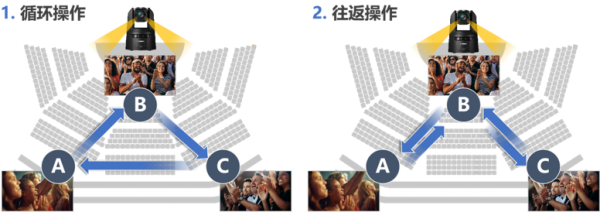

自动巡视“RA-AL001”应用程序可以自动重复执行摄影师设定的摄控一体机巡视位,并让摄控一体机精细的进行平移/俯仰/缩放(PTZ)的分段操作。除了可以根据需求选择两种“重复巡视”模式外,还可以在屏幕上直接调整巡视位和巡视路线以及确定每个巡视点位的停留时间,并在巡视路线中设定巡视移动的速度等参数,功能设置简单,操作清晰便利。此外,淡入淡出功能可以让摄控一体机在设定的两个巡视位之间平滑地执行移动开始和移动停止时的加减速,从而实现如同专业摄像人员一般的操控。

自动巡视“RA-AL001”应用程序的循环操作和往返操作示意图

自动巡视“RA-AL001”应用程序的淡入淡出功能示意图

为更好的适应中国市场,进一步扩大佳能4K摄控一体机应用领域

佳能推出适配旗下可应用于远程视频制作的4K摄控一体机CR-N700、CR-N500、CR-N300的自动追踪“RA-ST001”应用程序和图像增强“RA-IA001”应用程序。两款软件虽然外置,但是性能强大,用户只需将摄控一体机连接到已安装智能程序的终端上,就可以轻松实现对选定目标的自动追踪或图像增强。

自动追踪“RA-ST001”应用程序搭载AI人脸识别技术,对于戴口罩和背对摄控一体机的追踪目标,也能快速精准锁定,实现顺畅追踪效果,且多人识别时目标可锁定不易丢失,最多可同时连接四台摄控一体机,并允许用户根据需求在多台摄控一体机之间灵活切换。图像增强“RA-IA001”应用程序则可使设备对选定区域内的部分图像画质进行增强并将视频竖幅输出,且能够以4K高清的画面质量呈现,并通过HDMI直出和RTMP推流双路同时输出。

自动追踪“RA-ST001”应用程序(左)与图像增强“RA-IA001”应用程序(右)

提升性能与操作的便利性,佳能将为摄控一体机产品提供版本升级

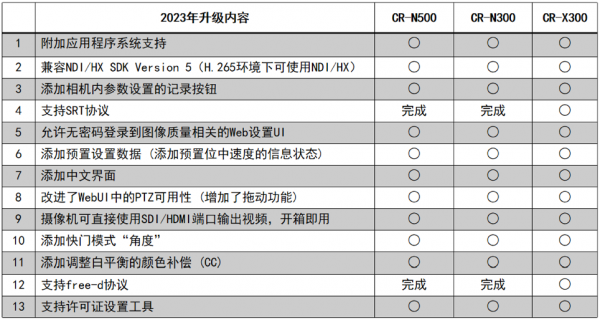

2023年4月佳能对摄控一体机CR-N500、CR-N300、CR-X300以及RCCA应用软件进行版本升级。通过本次固件升级,三款设备将支持中文显示,且兼容性会有明显提升。开箱即用可直接通过SDI/HDMI输出视频,同时,CR-X300通过本次固件升级还将支持“SRT协议”与“free-d协议”。此外,Mac版RCCA应用软件将进行版本升级,用户可于7月在官网下载。

CR-N500、CR-N300、CR-X300 固件升级明细

自动追踪“RA-AT001”与自动巡视“RA-AL001”预计将在今年4月下旬上市,自动追踪“RA-ST001”预计今年5月上旬上市。

好文章,需要你的鼓励

Allen AI团队推出SAGE:首个能像人类一样“想看多长就看多长“的智能视频分析系统

Allen AI研究所联合多家顶尖机构推出SAGE智能视频分析系统,首次实现类人化的"任意时长推理"能力。该系统能根据问题复杂程度灵活调整分析策略,配备六种智能工具进行协同分析,在处理10分钟以上视频时准确率提升8.2%。研究团队创建了包含1744个真实娱乐视频问题的SAGE-Bench评估平台,并采用创新的AI生成训练数据方法,为视频AI技术的实际应用开辟了新路径。

联想推出DE6600系列:更智能的存储解决方案

联想推出新一代NVMe存储解决方案DE6600系列,包含全闪存DE6600F和混合存储DE6600H两款型号。该系列产品延迟低于100微秒,支持多种连接协议,2U机架可容纳24块NVMe驱动器。容量可从367TB扩展至1.798PiB全闪存或7.741PiB混合配置,适用于AI、高性能计算、实时分析等场景,并配备双活控制器和XClarity统一管理平台。

AI视觉模型真的能看懂长篇文档吗?中科院团队首次揭开视觉文本压缩的真相

中科院团队首次系统评估了AI视觉模型在文本压缩环境下的理解能力,发现虽然AI能准确识别压缩图像中的文字,但在理解深层含义、建立关联推理方面表现不佳。研究通过VTCBench测试系统揭示了AI存在"位置偏差"等问题,为视觉文本压缩技术的改进指明方向。

数智时代,openGauss Summit 2025即将发布哪些技术创新破局

“算力+储能”深度融合:超智算发布分布式算力超级节点储能解决方案

联想推出DE6600系列:更智能的存储解决方案

创业公司如何在严格监管行业中实现生死攸关的创新

OpenAI发布GPT-5.2-Codex模型,软件工程自动化能力大幅提升

Waterfox浏览器宣布拒绝AI功能,瞄准Firefox忠实用户

TikTok美国业务出售交易将于下月完成

破局AI数据中心安全瓶颈:Fortinet联合NVIDIA引领隔离式加速新航向

智算中心进化论,科华数据如何做到“更懂”

更高负载、更快建设:2026年数据中心六大趋势

Snowflake数据库更新引发全球大规模服务中断

AI编程初创公司Lovable融资3.3亿美元,英伟达等科技巨头支持