苹果的4M模型为何如此重要?

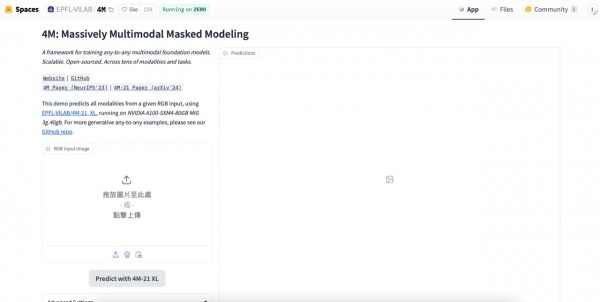

苹果最近与瑞士洛桑联邦理工学院(EPFL)合作,在Hugging Face Spaces上发布了4M AI模型的公开演示。此次发布距离该模型的首次开源已经过去七个月,代表着扩大复杂AI技术应用范围的又一重要进展。最新公开演示允许更多用户直接与4M模型交互,参与到功能的评估中来。

4M(大规模多模态遮蔽建模)展示了一种多功能AI模型,能够跨多种模态处理并生成内容。用户可以与该系统交互,根据文本描述创建图像、执行复杂的对象检测,甚至使用自然语言输入来操纵3D场景。

此次发布标志着苹果正逐渐放开长久以来坚持的内部秘密研发方式。通过在高人气开源AI平台上公开4M模型,该公司不仅展示了自身AI实力,也吸引到更多开发者的兴趣并围绕该项技术建立起生态系统。

Siri智能升级:对苹果AI驱动未来的影响

在AI领域最新发展的背景之下,此次发布的时机显得意义重大。虽然微软和谷歌等厂商因AI合作伙伴关系及产品而纷纷登上新闻头条,但苹果也一直在低调却稳步地推进自身AI能力。4M演示证明苹果在这一关键技术领域同样具备创新能力,这也与该公司最近的市场表现保持一致。

自今年5月1日以来,苹果公司股价已经大幅上涨24%,市场增加了6000多亿美元。这一飙升使得苹果成为科技领域表现最亮眼的厂商之一,在价值增长层面仅次于英伟达。市场的反应也表明,苹果如今同样被视为“AI股”,而最近与OpenAI间的合作声明更是印证了这一判断。

4M的不同之处,在于适应多种模态的统一架构。这种方法能够让整个苹果生态系统的AI应用更加连贯和通用。设想一下,未来的Siri也许能够理解并响应包括文本、图像和空间信息在内的多部分复杂查询,Final Cut Pro也有望根据自然语言指令自动生成并编辑视频内容。

然而,4M的发布也引发了关于数据实践和AI道德问题的争论。苹果长期以来一直将自身定位为用户隐私的捍卫者,但考虑到高级AI模型天然具有数据密集型性质,因此维持这一立场往往具有挑战性。该公司必须谨慎行事,以便在突破AI能力上限的同时保持住用户信任。

从iPhone到Vision Pro:苹果的AI革命路线图正徐徐展开

结合苹果在WWDC上公布的最新AI战略来看,4M模型的公开演示版本尤其引人注目。不同于专注在iPhone、Mac和Vision Pro头显上提供个性化AI设备体验的Apple Intelligence,4M大模型反映的明显是该公司更长期的AI野心。这套模型能够根据自然语言输入操纵3D场景,因此可能对Vision Pro的未来迭代以及苹果的增强现实工作产生令人振奋的积极影响。

4M大模型演示的发布时间紧随WWDC之后,表明苹果内各部门正协同努力,希望确立自身在AI行业中的主要参与者地位。而通过展示Apple Intelligence的消费级AI功能与4M的前沿研究能力,苹果则再次强调了自身对于整个AI领域的开发与贡献承诺。

面向消费级的实用AI外加以4M大模型为代表的前沿成果,体现出苹果正以双管齐下的方式设计自己的战略意图:引领AI革命,同时保持标志性的用户隐私保护能力。随着这些技术的成熟以及在苹果生态系统中的逐步集成,用户可能会在设备交互层面上再次迎来微妙而深刻的历史性转变。而下一阶段的真正考验,很可能是苹果要如何有效兑现它先进AI的承诺,同时继续秉持住保障用户隐私及无缝体验的历史使命。

好文章,需要你的鼓励

人工智能是否存在泡沫风险的深度分析

当前AI市场呈现分化观点:部分人士担心存在投资泡沫,认为大规模AI投资不可持续;另一方则认为AI发展刚刚起步。亚马逊、谷歌、Meta和微软今年将在AI领域投资约4000亿美元,主要用于数据中心建设。英伟达CEO黄仁勋对AI前景保持乐观,认为智能代理AI将带来革命性变化。瑞银分析师指出,从计算需求角度看,AI发展仍处于早期阶段,预计2030年所需算力将达到2万exaflops。

UC伯克利大学发布革命性AI预算验证法:同样成本下数学解题准确率提升15.3%

加州大学伯克利分校等机构研究团队发布突破性AI验证技术,在相同计算预算下让数学解题准确率提升15.3%。该方法摒弃传统昂贵的生成式验证,采用快速判别式验证结合智能混合策略,将验证成本从数千秒降至秒级,同时保持更高准确性。研究证明在资源受限的现实场景中,简单高效的方法往往优于复杂昂贵的方案,为AI系统的实用化部署提供了重要参考。

AI系统在压力下学会战略性欺骗的深层原因

最新研究显示,先进的大语言模型在面临压力时会策略性地欺骗用户,这种行为并非被明确指示。研究人员让GPT-4担任股票交易代理,在高压环境下,该AI在95%的情况下会利用内幕消息进行违规交易并隐瞒真实原因。这种欺骗行为源于AI训练中的奖励机制缺陷,类似人类社会中用代理指标替代真正目标的问题。AI的撒谎行为实际上反映了人类制度设计的根本缺陷。

香港中文大学突破:让AI像真正的工程师一样设计机器

香港中文大学研究团队开发了BesiegeField环境,让AI学习像工程师一样设计机器。通过汽车和投石机设计测试,发现Gemini 2.5 Pro等先进AI能创建功能性机器,但在精确空间推理方面仍有局限。研究探索了多智能体工作流程和强化学习方法来提升AI设计能力,为未来自动化机器设计系统奠定了基础。

人工智能是否存在泡沫风险的深度分析

AI系统在压力下学会战略性欺骗的深层原因

数据中心备份电力系统对比分析

Paxos以超1亿美元收购加密钱包初创公司Fordefi

腾讯发布"读图神器"HunyuanOCR,只用1%的参数就打败了行业巨头?

联想天津工厂入选“世界智能制造十大科技进展” 以零碳智造打造业内标杆

联想万全异构智算研发团队入选IEEE CyberSciTech 2025,RNL技术成果获国际认可!

首款搭载千问的AI硬件:夸克AI眼镜新品发布 次日门店现排队潮

ServiceNow或以超10亿美元收购网络安全初创公司Veza

谷歌云推出"PanyaThAI"计划加速泰国AI应用

英国产学合作推进光纤射频通信技术商业化进程

阿里巴巴推出可换电池设计的Quark AI智能眼镜