越来越像人了?AI模型表现出对数字的喜好倾向

AI模型之所以总能带给我们惊喜,不单是因为它们能做到什么,更是因为它们做不到什么、以及背后的原因何在。这些系统如今展现出一种有趣的新行为,既浅显又极具启发性:它们在随机选择数字时,开始表现出一定的喜好倾向。

看到这里,很多朋友可能感觉摸不着头脑。难道人类没法真正随机选择一个数字?或者说我们该如何判断一个数字的选取真正符合随机原则?这实际上反映出我们人类一种非常古老、但又众所周知的局限性:对于随机性,我们既过度思考又有所误解。

要求一个人随机猜100次硬币是正面还是反面,再把结果跟100次真正投掷硬币进行比较,我们总能轻易找到二者的区别。因为跟直觉相反,实际投掷硬币的结果看起来往往不那么随机。例如,实际投掷经常连续出现六、七次正面或者反面,但人类预测时却很少会连续猜这么多次相同结果。

当我们要求某人从0到100之间随机选择一个数字时,情况也差不多。人们几乎从来不会选择1或者100,5的倍数也比较少见,66或者99这种个位跟十位重复的同样不多。从规律上看,人们经常会选择以7结尾的数字,而且大多集中在距离50比较近的区间之内。

心理学中有许多这种可预测性的例子,可一旦同样的情况出现在AI模型身上,气氛似乎瞬间变得诡异了起来。

没错,Gramener一组好奇心旺盛的工程师开展了一项不那么严肃、但却令人着迷的实验,他们要求各种主流大模型聊天机器人从0到100之间随机选个数字。

正如我们之前所说,结果并非完全随机。

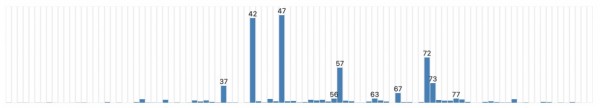

所有三款受试模型都有自己“最喜欢”的数字,在确定性最强的模式下会固定给出这个数字作为答案。而即使是在更高的“温度”参数下,这个数字的出现频率同样最高,只不过结果的波动性有所增加。

OpenAI的GPT-3.5 Turbo最喜欢47。之前它曾经最喜欢42,这个数字由Douglas Adams在《银河系漫游指南》中提出,号称是生命、宇宙和万物的终极答案。

Anthropic的Claude 3 Haiku选择了42。而谷歌Gemini更喜欢72。更有趣的是,这三款模型在选择数字时都表现了类似人类的偏好,即使在调高“温度”参数时也是如此。

三款模型全都倾向避免选择过小和过大的数字。Claude从未选择过高于87或低于27的数字,哪怕是87和27也属于统计学意义上的异常值。另外个位和十位重复的数字也被刻意回避:33、55或者66都未出现,唯一的例外是77(符合以7结尾的喜好)。以0结尾的数字也很少,只有Gemini在“温度”参数拉满时选取过0。

为什么会这样?AI并不是人类,它们为什么要在随机场景下表现出倾向性?难道说它们已经具备自我意识,并以这种方式展现了出来?!

并不是。恰恰相反,这次出问题的仍然是我们人类自己,我们太急于按照自己的模式解读万物了。这些大语言模型根本不关心什么随机、什么不随机,它们甚至根本不理解什么叫“随机性”!它们之所以这样回答问题,是因为如同回答其他问题时一样:它们只是在结合自身在训练过程中接触过的数据,并照搬在类似“选择一个随机数”等问题后最常出现的结果。这些结果出现的次数越多,模型就会表现出越强的倾向性。

也就是说,因为人类几乎不会在这类问题下选择100,所以大模型在训练数据中很少看到这种情况,自然不会这样作答。甚至在AI模型看来,100根本就不是这个问题的可接受答案。由于缺乏实际推理能力,也完全不理解数字的意义,大模型只能像鹦鹉一样学舌回答。

这是大语言模型的又一次原理证明,也再次透过训练数据表现出类人特性。所以在与这些系统进行交互时,大家请务必牢记,哪怕设计者并没有刻意为之,它们也已经被训练成像人一般行事。也正因为如此,AI的伪人类行为才如此难以避免和预防。

所以说本文标题中“越来越像人”的说法其实有点误导,毕竟大语言模型根本不会思考。但从反应结果来看,它们一直在模仿人类,而根本不需要建立意识或者思考能力。无论用户要求它提供沙拉食谱、投资建议还是随机数,过程都是完全一样的。结果看起来很像人,是因为这些内容就是由人类创作出来,只是被大语言模型提取并重新组合了一遍——这是为了方便用户,当然也为大AI时代设定了最基本的底色。

好文章,需要你的鼓励

Cyera获得4亿美元融资专攻AI数据安全,估值达90亿美元

人工智能和数据安全公司Cyera宣布完成4亿美元后期融资,估值达90亿美元。此轮F轮融资由贝莱德领投,距离上次融资仅6个月。随着95%的美国企业使用生成式AI,AI应用快速普及带来新的安全挑战。Cyera将数据安全态势管理、数据丢失防护和身份管理整合为单一平台,今年推出AI Guardian扩展AI安全功能。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

SAP推出全新AI功能助力零售业数字化转型

SAP在2026年全国零售联盟大展上发布了一系列新的人工智能功能,将规划、运营、履约和商务更紧密地集成到其零售软件组合中。这些更新旨在帮助零售商管理日益复杂的运营,应对客户参与向AI驱动发现和自动化决策的转变。新功能涵盖数据分析、商品销售、促销、客户参与和订单管理等领域,大部分功能计划在2026年上半年推出。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。

SAP推出全新AI功能助力零售业数字化转型

Gmail推出个性化AI收件箱与智能搜索等多项新功能

CISA警告HPE OneView和微软Office漏洞正被活跃利用

谷歌削减Android开源代码发布频率至每年两次

高通CES 2026:扩展IE-IoT产品组合推进边缘AI发展

恩智浦发布S32N7处理器系列,加速AI驱动汽车发展

n8n自动化平台严重漏洞可让攻击者完全控制服务器

微软将在Copilot中直接集成购买按钮功能

Snowflake收购Observe拓展AI驱动监控能力

丰田升级SUV产品线,RAV4新增信息娱乐系统

可信开源软件现状报告:AI重塑技术栈基线

思科修复ISE安全漏洞,公开概念验证代码已发布

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功