经常用AI做视频?YouTube要求创作者主动标记

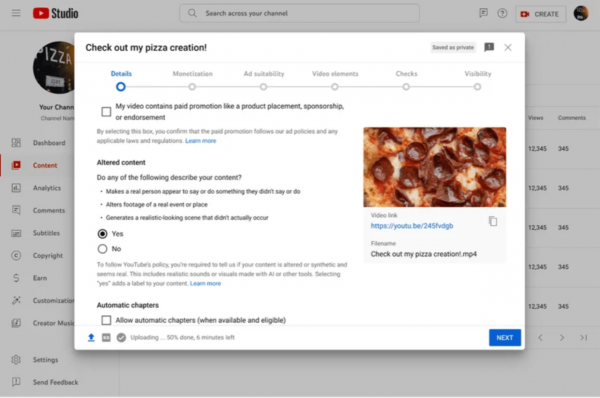

YouTube本周宣布,后续创作者需要向观众明确标注使用AI技术制作的视频内容。该平台在Creator Studio中引入了新工具,强调在可能被观众们误以为是真实人物、地点或事件的编辑/合成内容(包括由生成式AI输出的内容)处,创作者必须做出明确标记。

这项新规旨在防止用户受到蒙蔽,即误认为合成视频为真实素材,这是因为新的生成式AI工具已经让视频内容的真伪区别愈发困难。值此发布之际,专家们也再次警告称,AI与deepfakes深度伪造很可能在即将到来的美国总统大选期间掀起又一波误导风险。

此次发布的新规,也是YouTube继去年11月公布的大规模AI应用政策的延续与最新条款。

YouTube方面表示,新规并不要求创作者标记那些明显不太真实或者动画形式的内容,例如有人骑着独角兽穿越奇幻世界。新规也不要求创作者标明使用生成式AI进行辅助制作的内容,例如生成剧本或者自动字幕。

相反,YouTube的目标是帮助观众正确区分包含真实人物肖像的视频。例如,YouTube强调创作者必须披露自己在哪些部分对内容进行过数字编辑,包括“用其他人的面孔对当前人物进行换脸,或者用特定人物的合成音色为视频添加旁白。”

创作者还必须标明对真实事件或地点进行过编辑的镜头内容,例如用AI工具为一座真实建筑添加燃烧效果。同样受到限制的还有在真实场景下表现的重大虚构事件,例如龙卷风向真实存在的某处城镇移动。

YouTube表示,大多数视频只需要在扩展描述中添加“AI生成”标签。但对于涉及健康或新闻等较为敏感的主题视频,该公司要求创作者在视频画面处添加更显眼的标记提示。

未来几周内,观众将陆续在所有YouTube视频中看到这些标签信息。新规将首先登陆YouTube移动版应用,随后很快覆盖桌面及电视端视频。

YouTube还计划对坚持不添加标签的创作者采取强制措施。该公司表示,对于创作者没有自主添加标签的某些特定情况,YouTube会主动为其添加标签,特别是那些有可能混淆视听或误导人们认知的内容。

好文章,需要你的鼓励

AI智能体漏洞挖掘成本骤降,Anthropic呼吁AI防御

Anthropic发布SCONE-bench智能合约漏洞利用基准测试,评估AI代理发现和利用区块链智能合约缺陷的能力。研究显示Claude Opus 4.5等模型可从漏洞中获得460万美元收益。测试2849个合约仅需3476美元成本,发现两个零日漏洞并创造3694美元利润。研究表明AI代理利用安全漏洞的能力快速提升,每1.3个月翻倍增长,强调需要主动采用AI防御技术应对AI攻击威胁。

NVIDIA联手多所高校推出SpaceTools:AI机器人有了“火眼金睛“和“妙手回春“

NVIDIA联合多所高校开发的SpaceTools系统通过双重交互强化学习方法,让AI学会协调使用多种视觉工具进行复杂空间推理。该系统在空间理解基准测试中达到最先进性能,并在真实机器人操作中实现86%成功率,代表了AI从单一功能向工具协调专家的重要转变,为未来更智能实用的AI助手奠定基础。

Spotify年度盘点2025首次推出多人互动功能“盘点派对“

Spotify年度总结功能回归,在去年AI播客功能遭遇批评后,今年重新专注于用户数据深度分析。新版本引入近十项新功能,包括首个实时多人互动体验"Wrapped Party",最多可邀请9位好友比较听歌数据。此外还新增热门歌曲播放次数显示、互动歌曲测验、听歌年龄分析和听歌俱乐部等功能,让年度总结更具互动性和个性化体验。

机器人学会“三思而后行“:中科院团队让AI机器人告别行动失误

这项研究解决了现代智能机器人面临的"行动不稳定"问题,开发出名为TACO的决策优化系统。该系统让机器人在执行任务前生成多个候选方案,然后通过伪计数估计器选择最可靠的行动,就像为机器人配备智能顾问。实验显示,真实环境中机器人成功率平均提升16%,且系统可即插即用无需重新训练,为机器人智能化发展提供了新思路。

AI测试成数智化合规必选项,驱动企业高质量发展

AI智能体漏洞挖掘成本骤降,Anthropic呼吁AI防御

Spotify年度盘点2025首次推出多人互动功能"盘点派对"

英国SAP用户因商业套件重启授权迷局感到困惑

AWS发布Graviton5定制CPU,为云工作负载带来强劲性能

美光放弃Crucial品牌:告别消费级存储市场

手机里的NPU越来越强,为什么AI体验还在原地踏步?

如何使用现有基础设施让数据做好AI准备

IT领导者快问快答:思科光网络公司首席数字信息官Craig Williams分享AI转型经验

Anthropic CEO警告AI行业泡沫化,批评"YOLO"式投资

雅虎利用AI实时总结橄榄球比赛精彩内容

押注AI智能体,奇奇科技跨越十年的“换挡”与远航

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功