基本就是AGI?GPT-4o“它”来了 原创

OpenAI昨晚发布的GPT-4o给许多智能助理丢下一颗震撼弹。它不仅是一款强大的多模态AI助理,同时,为了应对Google Gemini的免费策略,OpenAI也让它免费了。

GPT-4o其中的“o”代表“Omni”,也就是“全能”的意思,可见OpenAI对它的表现充满了自信。不仅如此,OpenAI还为macOS用户推出ChatGPT的桌面应用,不仅可以向ChatGPT提问,还能读取用户的屏幕截图。

GPT-4o的最大特点在于,它支持文本、音频、图像任意组合的输入,同时也能以这样的任意组合输出,而且能够接受最短232毫秒、平均320毫秒的音频输入,简单来说,GPT-4o的反应速度就像真实的人类一样。

在英文和代码处理能力上,GPT-4o与GPT-4 Turbo性能不相上下,但是GPT-4o已经可以直接在ChatGPT的网站使用。在非英文的能力上,GPT-4o有着明显的提升,而且API速度也更快,成本也更低。

GPT-4o提供了GPT-4级别的智能,同时改进了文本、视觉和音频方面的能力。OpenAI CTO Muri Murati表示,这些模型将越来越复杂,但交互体验需要变得更简单和自然,让用户忘记交互界面,只关注与GPT的协作上。

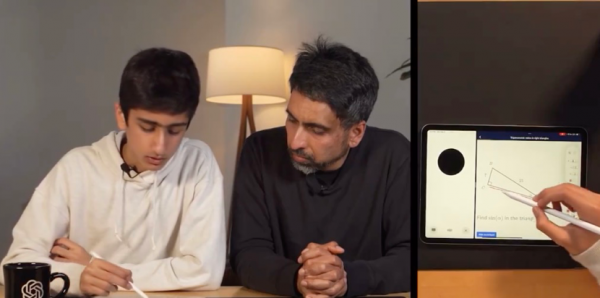

在演示过程中,工程师在iPhone上和GPT-4o进行了一次“视频通话”,它对即时的信息反应相当迅速,还能很好地理解人类情感,同时也能表现出丰富的情感。在视觉能力上,它也能通过手机的摄像头实时帮助工程师完成数学题甚至几何题的运算。

这么强大的能力,也让GPT-4o发布几个小时,就迅速在社交媒体上引发争论。

Nvidia高级科学家Jim Fan在X上表示:“OpenAI正在竞争中远超Character AI”,他也指出,以往OpenAI刻意压制的更具情感和个性化的AI特性,如今已经成为它迭代的方向。

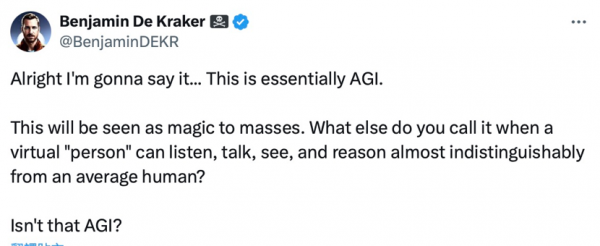

AI开发者Benjamin De Kraker更感叹GPT-4o基本上就是AGI(通用人工智能):“这基本上就是AGI,这会被视为一个奇迹。当一个虚拟人能听、说、看,并且具备和人类几乎无异的推理能力时,人们还能怎么称呼它呢?”

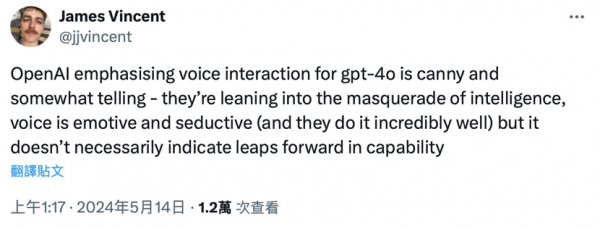

与此同时,网络上也有一些质疑的声音。记者和作家James Vincent表示,将GPT-4o作为语音助手的推广方法很精明,但这最终只是“智能的伪装”,因为“声音的表现并不一定预示着能力的飞跃”。

对AI技术持反对意见的Artisanal Holdout表示:“OpenAI对GPT-5没有信心,在GPT-4发布一年多后才推出了GPT-4o。这对OpenAI和AI爱好者来说都是一种尴尬。”

不过,Google预计也会在北京时间5月15日凌晨的I/O大会上公布自己的大模型进展,而且Gemini早已取代Google Assistant,成为Android系统内置的虚拟助理。

不论是大模型还是虚拟助理方面,OpenAI已经抢尽风头,Google一定做好了准备迎接这场挑战。在I/O大会之后,OpenAI还会不会有什么别的动作也很难说呢。

好文章,需要你的鼓励

至暗5小时警示,什么样的基础设施才算“韧性”?

Akamai的分布式边缘架构从设计之初就以韧性为核心,全球平台通过跨区域负载均衡和智能路由技术,确保即使某些节点出现故障,流量也能无缝切换至可用节点。

卡内基梅隆大学突破性研究:无需训练数据也能让AI学会图像编辑

卡内基梅隆大学联合Adobe开发出革命性的NP-Edit技术,首次实现无需训练数据对的AI图像编辑。该技术通过视觉语言模型的语言反馈指导和分布匹配蒸馏的质量保障,让AI仅用4步就能完成传统50步的编辑任务,在保持高质量的同时大幅提升处理速度,为图像编辑技术的普及应用开辟了全新道路。

AI工作负载两年内将主导数据中心建设

Turner & Townsend发布的2025年数据中心建设成本指数报告显示,AI工作负载激增正推动高密度液冷数据中心需求。四分之三的受访者已在从事AI数据中心项目,47%预计AI数据中心将在两年内占据一半以上工作负载。预计到2027年,AI优化设施可能占全球数据中心市场28%。53%受访者认为液冷技术将主导未来高密度项目。电力可用性成为开发商面临的首要约束,48%的受访者认为电网连接延迟是主要障碍。

复旦大学团队突破AI生成“复制粘贴“痛点:让多人脸AI不再千人一面

复旦大学团队突破AI人脸生成"复制粘贴"痛点,开发WithAnyone模型解决传统AI要么完全复制参考图像、要么身份差异过大的问题。通过MultiID-2M大规模数据集和创新训练策略,实现保持身份一致性的同时允许自然变化,为AI图像生成技术树立新标杆。

什么是神经符号AI

达索系统推出SOLIDWORKS 2026, 以面向生成式经济的AI赋能设计与

汇丰PayMe成功迁移至亚马逊云科技 加速推动香港电子支付创新

AI工作负载两年内将主导数据中心建设

AWS投资500亿美元为美国政府建设AI基础设施

微软发布Fara-7B智能体模型,可在PC端本地运行控制计算机

Monday.com:AI技术助力解决现代工作效率危机

Google联手Accel寻找印度下一代AI突破企业

数据价值化之上,东软目标做智能世界的“可靠伙伴”

微软CEO萨提亚:Excel为什么40年不倒?因为它是世界上最平易近人的编程环境,如果企业没有自己的模型,就不需要存在了

连接技术,赋能智能化与绿色化未来的“神经网络”

Anthropic发布Opus 4.5版本,集成Chrome和Excel新功能

当超1/4美国高中生用ChatGPT学习:一场静默的教育革命正在发生

Sam Altman最新博文《反思》:有信心构建AGI,2025年首批AI智能体将“加入劳动力大军”

惊喜!Sam Altman确定OpenAI新产品,AGI、Agents、成人模式

2024,AI这一年

ChatGPT可视频通话,距离“Her”越来越近 (Day 6/12)

突破性功能!OpenAI发布ChatGPT Projects,万能工具箱上线!

谷歌发布双思维AI Agent:像人类一样思考,重大技术突破!

OpenAI精心打造的Sora视频生成工具疑遭泄露

王者归来!Greg重返OpenAI,主抓重大技术创新

突发!OpenAI正式发布ChatGPT网络搜索,彻底颠覆谷歌!