音视频全都要!Pika不再是单纯的视频生成工具 原创

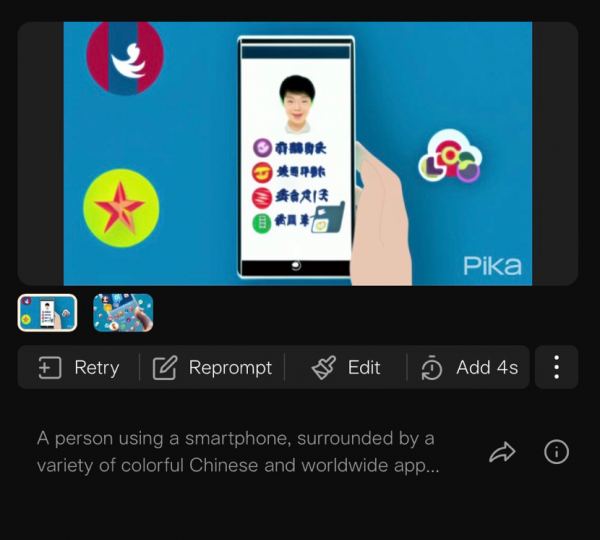

给猫咪戴上墨镜、让麦田圈变成甜甜圈、在沙滩上显示你的名字…… 三言两语就能让AI生成一段视频,从早期的Runway到Pika,再到前阵子引起热议的Sora,每款产品出现,舆论都直指好莱坞,视频制作的门槛立刻被拉了下来。

其实Pika Labs的成立到现在也不过一年时间,去年11月29日,Pika 1.0发布时,宣传视频展现出惊艳的生成效果,只有4人的小团队,加上创始人是从斯坦福退学的两位年轻华裔女性,让Pika在当时变得极具话题性,也在中国引起热议。

不过Pika生成视频的效果至今没有什么进步,看起来也很难与Sora抗衡,所以目前Pika也只是更多地在功能和使用体验上下功夫。

在短短不到半年时间里,Pika增加了不少新功能,不仅能根据视频画面生成音效,还能为人物对口型,最近还推出了风格选项。Pika正试图把自己打造成一个“all in one”的视频制作工具,从画面到声音,一手包办。

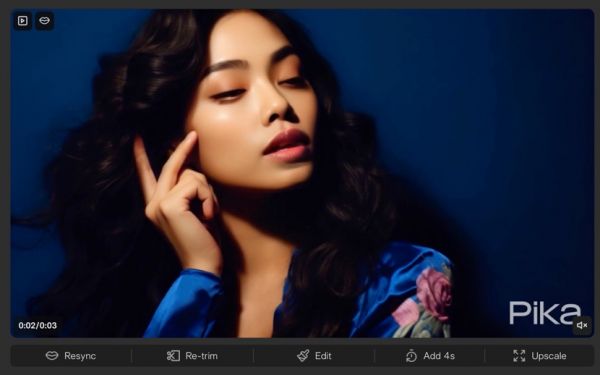

Pika非常好上手,除了可以上传照片和视频外,使用方法基本和ChatGPT无异——输入你的指令,发送出去就行了。不过Pika比较麻烦的是,每次只能生成3秒钟的视频,如果想用Pika制作较长的视频,需要订阅它的几档付费计划,这样就能直接在上一次生成的3秒钟视频里接续生成后面的内容。

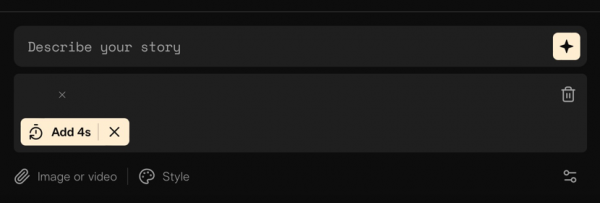

不过在生成完的视频下方点选“Add 4s”后的对话框界面,可以看出,它延长视频时间的方法,也只是在上一次生成的视频画面基础上,搭配提示词,而且也只能生成4秒钟而已。

所以我也可以截取生成完视频的最后一帧,配合提示词,让之前生成的故事延续3秒钟。

不过和许多生成式AI一样,Pika生成的内容也有一定的不可控性,想要最好的效果,不仅要精心设计提示词,也需要多多试错。

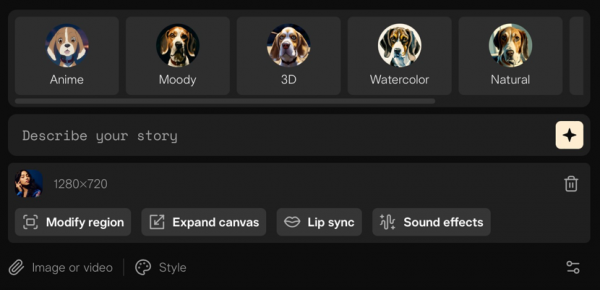

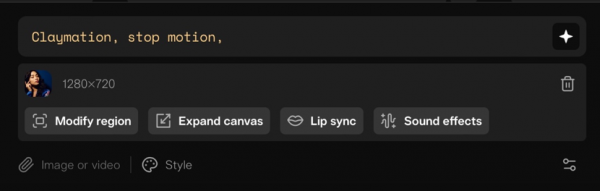

在修改视频的步骤上,Pika最近推出了修改风格(Styles)的选项,提供动漫、阴郁、3D、水彩、自然、粘土动画、黑白7种选择。

在实际选择一种风格后,就能看到一句提示词,说明这些改变风格的选项本质上还是通过输入提示词来实现的。

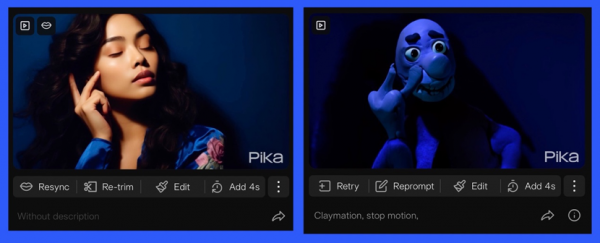

对比生成效果,构图虽然没有多大变化,风格夜的确是粘土动画,但整体的颜色还有任务的神态并没有很好的还原出来。

可能是为了弥补视频生成能力的不足,所以Pika一直在丰富自己的功能。前阵子还加入了音效(Sound Effects)生成能力,简单来说,就是让Pika识别视频内容,并搭配一段合适的音效。

有时候Pika为视频生成的音效完全看不出与视频本身有任何关联性,所以Pika每次都会提供三种音效供选择,这也许也算是一种“补救措施”吧。

不过生成的音效到底能用,还是取决于视频内容,如果没有明显的场景,Pika可能也难以决定放怎样的音效比较适合。

比如烟花的画面就比一间会议室或简单的人像更容易识别,你甚至不需要额外补充提示词,它就能生成完全符合画面内容的音效。

如果是人像画面,其实对口型(Lip sync)功能更适合它,只是这个功能与Pika的主要能力关联性不是很强,因为这个选项需要上传视频或照片,或者在生成好的视频里面点“编辑”按钮才能出现,而不是在文生图的过程中“顺便”完成一下。

可以输入文字,选择几个预设的声音,让他们帮你朗读,或者直接上传音频,根据音频内容对口型。

朗读的声音还是比较自然的,而且讲中文的语气也挺自然的,但问题是口型不太自然,能看得出是AI生成的。

Pika目前给我一种“泛而不精”的印象,什么功能都要沾一点,但表现都不尽如人意。也许现在的Pika定位娱乐体验多于生产力,从输入框旁边的骰子按钮就能看出这一点。

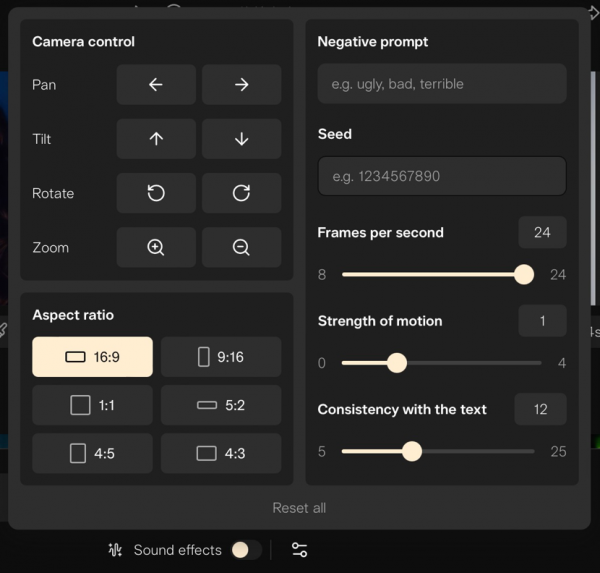

不过Pika也在丰富各种功能,而且每一项功能的使用体验都可以说相当精美,对于生成视频的画面比例、反向提示词、运动强度等等也有专门的区域做调整,甚至还提供了文件夹方便管理生成的项目,可以看出它在生产力上面也有十足的野心。

好文章,需要你的鼓励

Allen AI团队推出SAGE:首个能像人类一样“想看多长就看多长“的智能视频分析系统

Allen AI研究所联合多家顶尖机构推出SAGE智能视频分析系统,首次实现类人化的"任意时长推理"能力。该系统能根据问题复杂程度灵活调整分析策略,配备六种智能工具进行协同分析,在处理10分钟以上视频时准确率提升8.2%。研究团队创建了包含1744个真实娱乐视频问题的SAGE-Bench评估平台,并采用创新的AI生成训练数据方法,为视频AI技术的实际应用开辟了新路径。

联想推出DE6600系列:更智能的存储解决方案

联想推出新一代NVMe存储解决方案DE6600系列,包含全闪存DE6600F和混合存储DE6600H两款型号。该系列产品延迟低于100微秒,支持多种连接协议,2U机架可容纳24块NVMe驱动器。容量可从367TB扩展至1.798PiB全闪存或7.741PiB混合配置,适用于AI、高性能计算、实时分析等场景,并配备双活控制器和XClarity统一管理平台。

AI视觉模型真的能看懂长篇文档吗?中科院团队首次揭开视觉文本压缩的真相

中科院团队首次系统评估了AI视觉模型在文本压缩环境下的理解能力,发现虽然AI能准确识别压缩图像中的文字,但在理解深层含义、建立关联推理方面表现不佳。研究通过VTCBench测试系统揭示了AI存在"位置偏差"等问题,为视觉文本压缩技术的改进指明方向。

数智时代,openGauss Summit 2025即将发布哪些技术创新破局

“算力+储能”深度融合:超智算发布分布式算力超级节点储能解决方案

联想推出DE6600系列:更智能的存储解决方案

创业公司如何在严格监管行业中实现生死攸关的创新

OpenAI发布GPT-5.2-Codex模型,软件工程自动化能力大幅提升

Waterfox浏览器宣布拒绝AI功能,瞄准Firefox忠实用户

TikTok美国业务出售交易将于下月完成

破局AI数据中心安全瓶颈:Fortinet联合NVIDIA引领隔离式加速新航向

智算中心进化论,科华数据如何做到“更懂”

更高负载、更快建设:2026年数据中心六大趋势

Snowflake数据库更新引发全球大规模服务中断

AI编程初创公司Lovable融资3.3亿美元,英伟达等科技巨头支持

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功