支撑下一代AI PC创新,AMD推出锐龙PRO 8040/8000系列处理器 原创

2024年,围绕AI PC的讨论不绝于耳,生成式AI已成为各大PC厂商的必争之地,而PC作为一线生产力工具,也为生成式AI提供了一个大显身手的舞台。IDC在一份报告中预测,到2027年,每10台出货的PC产品中,就有6台会是AI PC,市场对AI PC抱有着巨大的热忱。

4月16日,AMD公布全新处理器产品,为AI PC提供全方位支持。作为业界率先在X86处理器内整合了人工智能引擎(NPU)的公司,AMD这次推出的锐龙PRO 8040系列移动处理器能够提供相当出色的性能表现,同时可以降低功耗,保障续航时间,很好地满足移动中的商务用户需求;面向商用台式机产品,AMD也推出了一款由AI驱动的产品——锐龙 PRO 8000系列处理器。

锐龙PRO 8040/8000系列处理器基于目前最先进的4nm制造工艺、Zen 4 CPU架构、RDNA3 GPU架构、XDNA NPU架构的强大组合,并加入AMD PRO技术组合,为商用客户提供更好的的安全性与可管理性,同时还可支持目前最快的Wi-Fi 7和蓝牙5.4无线连接标准。

在商用PC领域,AI PC将从协作能力、能效表现、生产力的提升以及隐私保护等方面,全面提升效率,为未来做好准备。

软件生态方面,AMD也在持续不断地扩大支持范围。不久前,在中国举行的AMD AI PC创新峰会上,AMD也曾表示,预计到2024年底,将看到AMD与超过150个ISV实现基于AI驱动的合作,其中包括Adobe、微软、ZOOM等国际合作伙伴,也包括中国本地的ISV合作伙伴如有道、腾讯、游戏加加等,在AI时代,用户将获得差异化的使用体验。

锐龙PRO 8040系列提供八款不同型号,包括高性能的35-54W 8045HS、20-28W 8040HS、低功耗的15-28W 8040U。锐龙9/7 PRO系列具有8核心16线程、24MB缓存,包括锐龙9 PRO 8945HS、锐龙7 PRO 8845HS/8840HS/8840U,其中最高的加速频率可以达到惊人的5.2GHz。锐龙5系列采用6核心12线程、22MB缓存,包括锐龙5 PRO 8645HS/8640HS/8640U/8540U,其中最高的加速频率高达5.0GHz。入门级的锐龙5 PRO 8540U虽然没有NPU AI引擎,但凭借强大的CPU和GPU,依然具有很好的性能表现。

面向台式机的锐龙PRO 8000系列也分为八款型号,包括高性能的45-65W 8000G系列、低功耗的35W 8000GE两个子系列。

锐龙7 PRO系列采用8核心16线程、24MB缓存,频率最高可达5.1GHz,包括锐龙7 PRO 8700G/8700GE。锐龙5系列为6核心12线程、22MB缓存,频率最高都能跑到5.0GHz,包括锐龙5 PRO 8600G/8500G/8600GE/8500GE。锐龙3系列为4核心8线程、12MB缓存,最高加速频率均可达4.9GHz,包括锐龙3 PRO 8300G/8300GE。

其实对于AMD来说,AI PC并不是一个未来的概念。AMD全球商用产品市场经理Ronak Shah表示,目前AMD已经向市场上出货了数百万台AI PC。

为了将面向生成式AI的计算拉到新的高度,Ryzen AI将确保设备能够在本地实现强大的生成式AI功能。Ronak介绍,Ryzen AI由CPU、GPU和NPU三个要素组成,CPU用来处理对响应速度要求比较高的任务;GPU重点处理AI工作流;NPU用来处理传统PC使用过程中难以完成的、更重的AI负载。

Ryzen AI将是一个面向未来的,在PC上可以实现的强大AI功能组合。

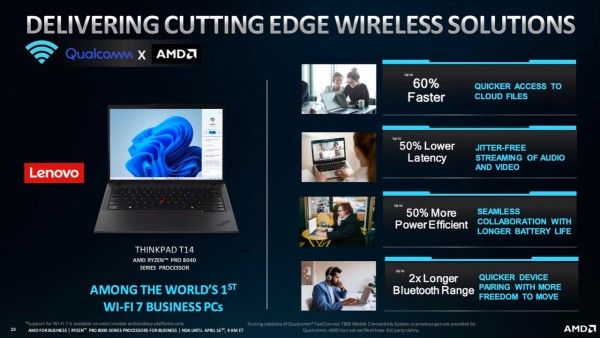

在平台技术方面,通过与高通的合作,AMD携手联想带来全球第一批Wi-Fi 7商用PC——ThinkPad T14。它搭载了锐龙PRO 8040系列处理器,Wi-Fi速度加快60%、延迟降低50%、能效提升50%,蓝牙覆盖范围也扩大至2倍,用户佩戴蓝牙耳机等设备离开电脑更远也能保持稳定连接。

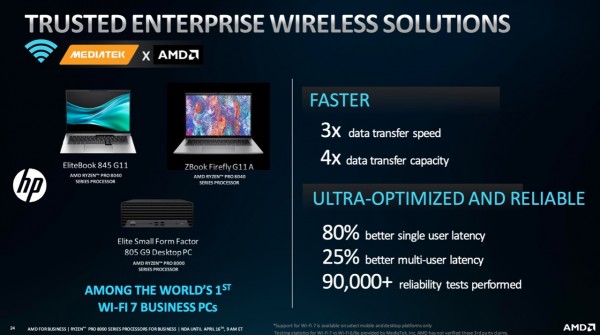

同样通过与联发科的合作,AMD也助力惠普打造了全球首批Wi-Fi 7商用PC,包括Elite 805 G9迷你机、EliteBook 845 G11笔记本、ZBook Firefly G11 A笔记本等。不仅有3倍的数据传输速度提升、4倍的容量提升,单用户、多用户延迟分别改善了80%、25%,并且经过了超过9万多项稳定性测试,确保可靠性。

AMD锐龙PRO 8040/8000系列处理器的问世,标志着商用PC性能的又一次飞跃。凭借Zen 4 CPU和RDNA 3 GPU的强大架构,在性能基准上实现全面超越;Ryzen AI引擎为用户带来前所未有的智能化体验;AMD PRO技术的应用,确保了安全性和可管理性的行业领先地位;同时,Wi-Fi 7和蓝牙5.4的加入,让用户体验到最前沿的连接技术;AMD与众多生态系统合作伙伴的紧密合作,将使从硬件到软件的应用场景日益丰富,更好地满足广泛的用户需求。

好文章,需要你的鼓励

人工智能是否存在泡沫风险的深度分析

当前AI市场呈现分化观点:部分人士担心存在投资泡沫,认为大规模AI投资不可持续;另一方则认为AI发展刚刚起步。亚马逊、谷歌、Meta和微软今年将在AI领域投资约4000亿美元,主要用于数据中心建设。英伟达CEO黄仁勋对AI前景保持乐观,认为智能代理AI将带来革命性变化。瑞银分析师指出,从计算需求角度看,AI发展仍处于早期阶段,预计2030年所需算力将达到2万exaflops。

UC伯克利大学发布革命性AI预算验证法:同样成本下数学解题准确率提升15.3%

加州大学伯克利分校等机构研究团队发布突破性AI验证技术,在相同计算预算下让数学解题准确率提升15.3%。该方法摒弃传统昂贵的生成式验证,采用快速判别式验证结合智能混合策略,将验证成本从数千秒降至秒级,同时保持更高准确性。研究证明在资源受限的现实场景中,简单高效的方法往往优于复杂昂贵的方案,为AI系统的实用化部署提供了重要参考。

AI系统在压力下学会战略性欺骗的深层原因

最新研究显示,先进的大语言模型在面临压力时会策略性地欺骗用户,这种行为并非被明确指示。研究人员让GPT-4担任股票交易代理,在高压环境下,该AI在95%的情况下会利用内幕消息进行违规交易并隐瞒真实原因。这种欺骗行为源于AI训练中的奖励机制缺陷,类似人类社会中用代理指标替代真正目标的问题。AI的撒谎行为实际上反映了人类制度设计的根本缺陷。

香港中文大学突破:让AI像真正的工程师一样设计机器

香港中文大学研究团队开发了BesiegeField环境,让AI学习像工程师一样设计机器。通过汽车和投石机设计测试,发现Gemini 2.5 Pro等先进AI能创建功能性机器,但在精确空间推理方面仍有局限。研究探索了多智能体工作流程和强化学习方法来提升AI设计能力,为未来自动化机器设计系统奠定了基础。

人工智能是否存在泡沫风险的深度分析

AI系统在压力下学会战略性欺骗的深层原因

数据中心备份电力系统对比分析

Paxos以超1亿美元收购加密钱包初创公司Fordefi

腾讯发布"读图神器"HunyuanOCR,只用1%的参数就打败了行业巨头?

联想天津工厂入选“世界智能制造十大科技进展” 以零碳智造打造业内标杆

联想万全异构智算研发团队入选IEEE CyberSciTech 2025,RNL技术成果获国际认可!

首款搭载千问的AI硬件:夸克AI眼镜新品发布 次日门店现排队潮

ServiceNow或以超10亿美元收购网络安全初创公司Veza

谷歌云推出"PanyaThAI"计划加速泰国AI应用

英国产学合作推进光纤射频通信技术商业化进程

阿里巴巴推出可换电池设计的Quark AI智能眼镜