AMD发布CDNA架构Instinct MI100加速显卡 加速百亿亿次级时代到来

11月16日晚10点,AMD正式发布了首款基于全新CDNA架构的Instinct MI100加速显卡,以及配套的ROCm 4.0生态系统。

首次正式亮相的CDNA架构专门为高性能计算所打造,而基于该架构的AMD Instinct MI100加速显卡将进一步逼近百亿亿次级计算时代,同时也是AMD向前方开拓新发展路径的新旗舰产品。

AMD高级副总裁兼服务器业务总经理Dan McNamara表示,在高性能计算方面,整个行业发展十分迅速。我们看到的趋势是,工作负载的多样性在不断增加,高性能计算已经进入到很多领域,包括从传统科研,气象研究,生命科学,电子设计自动化到商业应用,从AI、机器学习到算法培训等等,如何通过CPU和GPU方面的组合更好地服务于客户、为客户带来更多单位成本性能和减少总体拥有成本,将是AMD极其重要的战略之一。

不过最令用户之间关心的,相信还是本次发布的新品加速显卡。AMD平台解决方案工程研发全球副总裁Brad Mccredie对此进行了全面解读。

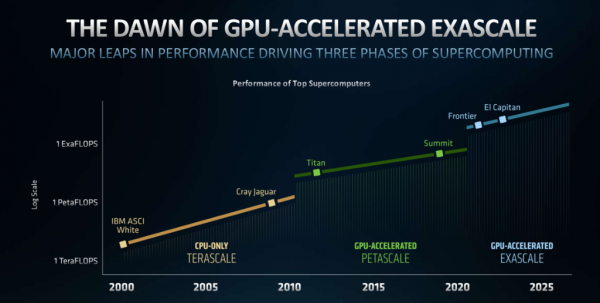

在整个过去20年里,整个高性能计算经历了三个阶段,分别是TERASCALE、PETASCALE和现在的EXASCALE。在这个过程中我们需要一系列技术来支持EXASCALE这样一个百亿亿次级计算。

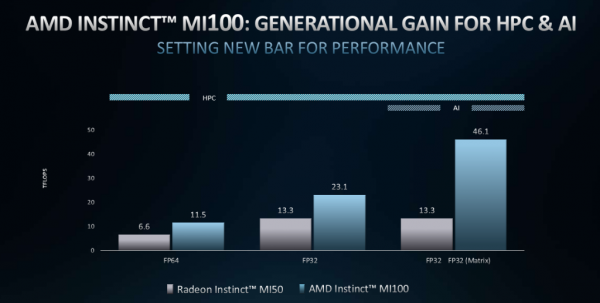

作为一款针对高性能计算而专门设计的行业领先GPU产品,AMD Instinct MI100旨在为推动百亿亿次级计算时代到来,能够实现10TF(十万亿次双精度计算速度),具备Matrix核心技术。与AMD上一代产品相比有着巨大的性能提升,能够实现高达70%的AI计算加强;而与竞争对手相比,在每单位性能上也是对方的两倍。特别是在搭配第二代AMD EPYC处理器使用时,还可为系统提供更强的加速性能。

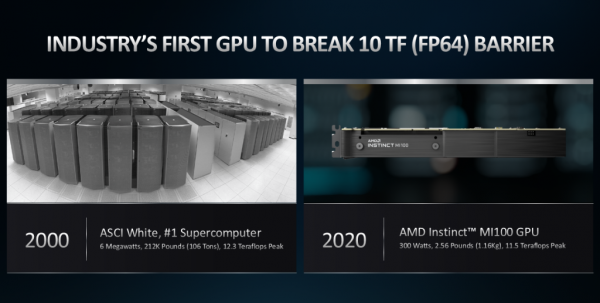

20年前ASCI White超级计算机进入超算领域,并率先突破10TF关卡。20年之后,现在单个GPU仅在6兆瓦的性能上就可实现这样一个性能水平,这就是AMD Instinct MI100加速显卡,可以说这就是20年后非常巨大的成就之一。

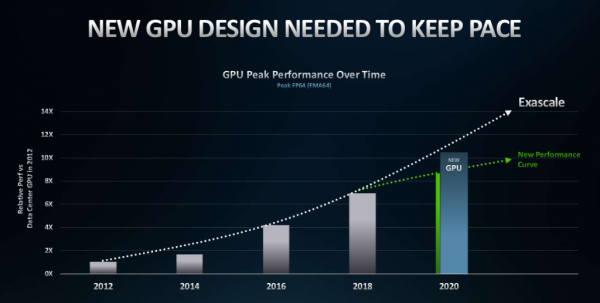

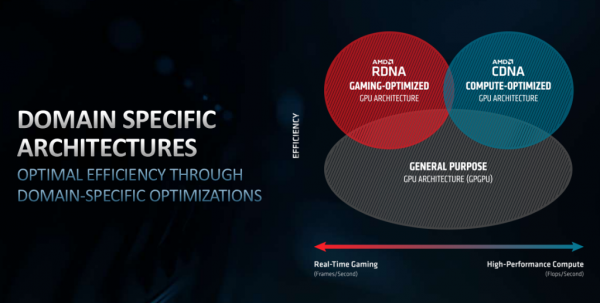

目前市面上的大部分GPU采用的都是通用架构,这意味着这个架构既用于游戏图形处理,也用于复杂数学方面的处理,实际上很大的制约了向百亿亿次级计算的发展。而AMD选择将这两部分分离,为我们已经所熟知的针对游戏行业的RDNA架构,以及针对超算计算的CDNA架构。这样的分离可以帮助相关人员进一步针对领域内的工作负载进行优化。

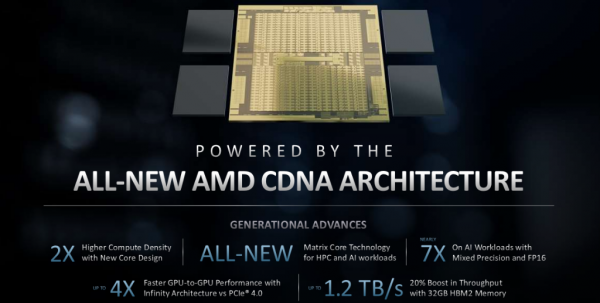

以AMD Instinct MI100为例,CDNA架构可在同一晶片上放入了两倍数量的计算单元,并可以嵌入微架构以更好的适应AI和高性能计算的工作负载。同时在16位浮点计算和混合精度计算方面也能实现7倍以上的性能提升,另外通过Infinity架构还可以将GPU的带宽提升4倍、通过HBM2内存来实现20%的位宽提升。

上文中多次提到的AMD Instinct MI100加速显卡正在进一步逼近百亿亿次级计算时代,而AMD Instinct MI100的双精度计算性能可以达到11.5TF的水平,单精度计算水平会更高。

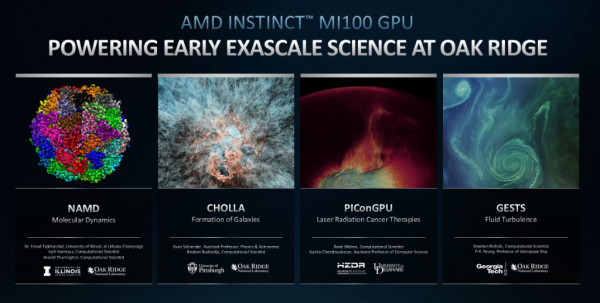

据介绍,橡树岭国家实验室就通过使用MI100来进行相关工作负载,在分子动力学负载中,与v100加速显卡相比速度提升3倍。而在Fluid Turbulence的工作负载中,也比v100加速显卡有2.6倍的速度优势。作为早期客户使用的效果来看,这一数据十分具有说服力。

另外,AMD还强调既要有世界级硬件,也需要世界级生态来做配套。为此,还推出搭配使用的开源软件站ROCm 4.0,为百亿亿次级计算提供了新基础。

该平台不仅相较上两代产品,可实现MI100高达5-8倍的性能提升,还可为开发者们提供简单快捷的代码迁移功能,甚至最短1天就可完成某些代码的迁移工作。

自代号为“罗马”的第二代霄龙处理器发布以来,AMD在服务器市场便收获了不俗的成绩,时至今日它仍是市面上行业领先的x86服务器。根据Intersect360此前的调查显示,从16年至今,用户对霄龙处理器的前瞻性印象和好感度增加了两倍之多。

如今,AMD在MI100加速显卡和ROCm 4.0开源平台的推出后,除了进一步完善AMD在服务器市场的产品布局外,相信也定将会为客户们带来更为优越的HPC工作基础,推动百亿亿次级时代抢先到来!

来源:至顶网商用办公频道

好文章,需要你的鼓励

Allen AI团队推出SAGE:首个能像人类一样“想看多长就看多长“的智能视频分析系统

Allen AI研究所联合多家顶尖机构推出SAGE智能视频分析系统,首次实现类人化的"任意时长推理"能力。该系统能根据问题复杂程度灵活调整分析策略,配备六种智能工具进行协同分析,在处理10分钟以上视频时准确率提升8.2%。研究团队创建了包含1744个真实娱乐视频问题的SAGE-Bench评估平台,并采用创新的AI生成训练数据方法,为视频AI技术的实际应用开辟了新路径。

联想推出DE6600系列:更智能的存储解决方案

联想推出新一代NVMe存储解决方案DE6600系列,包含全闪存DE6600F和混合存储DE6600H两款型号。该系列产品延迟低于100微秒,支持多种连接协议,2U机架可容纳24块NVMe驱动器。容量可从367TB扩展至1.798PiB全闪存或7.741PiB混合配置,适用于AI、高性能计算、实时分析等场景,并配备双活控制器和XClarity统一管理平台。

AI视觉模型真的能看懂长篇文档吗?中科院团队首次揭开视觉文本压缩的真相

中科院团队首次系统评估了AI视觉模型在文本压缩环境下的理解能力,发现虽然AI能准确识别压缩图像中的文字,但在理解深层含义、建立关联推理方面表现不佳。研究通过VTCBench测试系统揭示了AI存在"位置偏差"等问题,为视觉文本压缩技术的改进指明方向。

数智时代,openGauss Summit 2025即将发布哪些技术创新破局

“算力+储能”深度融合:超智算发布分布式算力超级节点储能解决方案

联想推出DE6600系列:更智能的存储解决方案

创业公司如何在严格监管行业中实现生死攸关的创新

OpenAI发布GPT-5.2-Codex模型,软件工程自动化能力大幅提升

Waterfox浏览器宣布拒绝AI功能,瞄准Firefox忠实用户

TikTok美国业务出售交易将于下月完成

破局AI数据中心安全瓶颈:Fortinet联合NVIDIA引领隔离式加速新航向

智算中心进化论,科华数据如何做到“更懂”

更高负载、更快建设:2026年数据中心六大趋势

Snowflake数据库更新引发全球大规模服务中断

AI编程初创公司Lovable融资3.3亿美元,英伟达等科技巨头支持

AMD 发布新一代 AMD RDNA(TM) 4 架构,推出 AMD Radeon(TM) RX 9000 系列显卡

苏姿丰的十年历程回顾:AMD如何从英特尔廉价替代品成长为x86领域的有力竞争者

面临AMD及自身内部挑战,英伟达Green 500主导地位受到威胁

微软率先拿下HBM驱动的AMD CPU供货

基于 AMD 加速器的 El Capitan 首次登全球超算500强榜首

突发!AMD大爆雷!

AMD Versal家族再添新成员 ——打破AI内存桎梏 支持CXL 3.1

AMD超低时延金融加速卡 帮你跑赢高频交易“竞速赛”!

要超越英伟达,AMD还须十年时间

深度剖析:聊聊英特尔与AMD各自不同的CPU整合思路