Redmi 10X告诉你:只用51%电量,就从星耀V上王者 原创

熟悉Redmi手机的一定知道,每次新机发布宣传都会铺下一个梗。继上次「最会保护自己的弹出式全面屏手机」Redmi K30 Pro后,这一次,Redmi又带着「最强王者」来了。

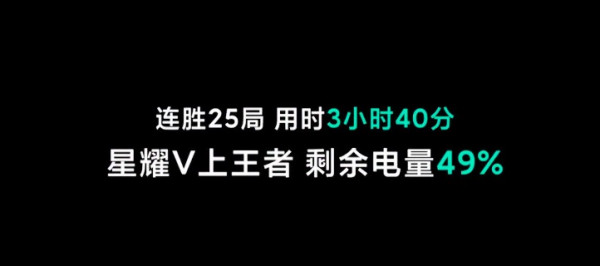

从星耀一打上王者需要多久,答案背后是单排玩家的心酸。但如果是大神上分,他的手机会告诉你,从星耀五上王者,只是3小时40分,51%电量,25连胜局而已。

这款手机就是Redmi 10X系列。

最新Redmi 10X系列包括三款机型,分别是Redmi 10X、Redmi 10X Pro、Redmi 10X 4G。

正如同名字X代表未知,你永远不知道这款手机的极限。全新推出的X系列是Redmi为全球年轻用户打造的“轻旗舰”手机,以比肩旗舰机的高性能处理器做基础,致力成为同级产品中的「性能王者」。

新X系列完善Redmi产品矩阵

2019年是Redmi品牌独立的第一年,Redmi推出了多款备受市场认可的产品。同时,Redmi也在不断完善自身产品线布局,以满足全球不同消费者的需求。

此次X系列是Redmi继性能旗舰K系列之后,推出的为全球年轻用户全新设计的“轻旗舰”。自此,Redmi拥有了更完善的产品矩阵:

数字系列定位「五星高品质入门机」,Note系列定位「潮流科技,先锋影像」,X系列定位「新锐科技,源于内“芯”」,K系列定位「极致科技,性能旗舰」,从千元至五千元的全价位段精细化布局,让Redmi有能力从各个维度满足全球用户的多样需求。

双5G待机,全球首发天玑820

天玑820处理器是Redmi这次在Redmi 10X系列上准备的“杀手锏”,其综合性能与去年高端旗舰骁龙855接近,安兔兔跑分超过41万,官方称其为5G手机处理器中的“中量级拳王”。

同时,Redmi 10X还是全球首批支持5G+5G的双5G待机,相比于当前主流的5G+4G双卡方案,Redmi 10 X的主副两张SIM卡可同时接入高速5G网络,根据网络环境在主副卡之间智能切换,配合360度防抱死天线设计,拥有超强5G信号,大幅改善高铁、高速、电梯、地库等复杂场景下的5G连接稳定性和速度,确保“Always-on 5G”的高速网络体验。

全系搭载4800万超清多摄相机,Redmi 10X Pro更是拥有OIS光学防抖变焦镜头,可实现最大3倍光学、30倍数码变焦。两款产品还配备同价位竞品中少有的三星AMOLED屏幕、线性马达和坚固的双面康宁GG5玻璃。

关于电量,Redmi 10X也十分自信,内置4520mAh大容量电池,Redmi 10X支持22.5W快充,Redmi 10X Pro升级为33W疾速闪充,并支持全功能NFC。毕竟从星耀V到王者,25连胜,用时3小时40分,还剩余电量49%,真的强悍。

而这样一款手机,价格也非常亲民,Redmi也将5G手机的门槛拉至1500元档,持续推动着5G的普及。

不过,Redmi也提供了相应的4G版机型——Redmi 10X 4G,全球首发Helio G85游戏处理器,标配128GB大存储,6.53英寸小孔全面屏,4800万全场景四摄,拥有指纹+人脸双重解锁,内置超大的5020mAh大电池,支持18W快充,同样适配MIUI12系统。

据悉,Redmi 10X将于6月1日发售,6GB+64GB版1599元,6GB+128GB版1799元,8GB+128GB版2099元,8GB+256GB版2399元;Redmi 10X Pro 6月5日发售,8GB+128GB版2299元,8GB+256GB版2599元;Redmi 10X 4G 5月26日发售,4GB+128GB版999元,6GB+128GB版1199元。

好文章,需要你的鼓励

致欧家居:全链调度提速、降本,重塑跨境家居电商“护城河”

跨境电商平台的崛起,让家居企业不再只做幕后生产者,而是以品牌形态直接触达全球消费者,逐渐从幕后走向台前。在这一潮流中,跨境家居电商赛道的“老玩家”,致欧家居科技股份有限公司(以下简称“致欧家居”)正通过数字化供应链,重塑跨境家居电商的“护城河”。

DeepSeek团队破解数学AI的“自我欺骗“难题:让机器真正学会数学推理

DeepSeek-AI团队开发的DeepSeekMath-V2突破了传统数学AI只关注答案正确性的局限,首次实现了AI的"自我验证"能力。该系统在2025年IMO竞赛中达到金牌水平,在2024年普特南竞赛中得分118/120,远超人类最高分。这项技术通过训练AI像数学专家一样检查和改进自己的推理过程,为AI辅助数学研究和教育开启了新的可能。

据说算力高达1000 TOPS,华硕Ascent GX10深度评测——多模态AI创作

华硕Ascent GX10 GPU采用了最新的Blackwell架构,这一架构针对Diffusion模型和Transformer等主流AI模型配备了专门的加速单元。

伊利诺伊大学与谷歌联手:AI如何让视频合成像“拆积木再拼装“一样自然

这项由伊利诺伊大学与谷歌联合开展的研究提出了"分离然后合并"(StM)的视频合成新方法,通过自动分解5万个视频片段创建了大规模训练数据集,解决了传统方法无法同时保持原始动作和实现环境适应的问题,让AI能像经验丰富的演员一样既保持特色又融入新场景。

对话Xperi郎正武:在最卷舞台为中国车企双向“摆渡”

戴尔科技Asset Recovery Services 革新企业IT资产管理体验

据说算力高达1000 TOPS,华硕Ascent GX10深度评测——多模态AI创作

Terminal安全技巧第三期:探索实用的命令行工具

Spacecoin卫星成功发射,去中心化卫星网络迎来关键突破

CTO专访:利用SnapLogic中间件平台驱动业务流程创新改造

Google测试将AI概览与AI模式合并功能

AWS re:Invent 2025 大会发布智能体新功能与AI训练芯片

卡尔动力,跨过Robotruck盈利拐点

2025 re:Invent :亚马逊云科技把Agentic AI生态梳理明白了

AI时代下,企业如何识别并构建面向未来的存储

微软关闭Mesh平台,元宇宙战略再遭挫折